L’autore è Sarah Thompson. Magari dice di non volere essere citata, però si pubblicizza sui social.

L’articolo di Thompson è molto qualitativo, non fa un’analisi quantitativa dei dati, come è giusto che sia per gli articoli divulgativi.

Nella pubblicazione di Arcas et al., invece, il paper linkato al primo post, ci sono risposte, sebbene non complete, alle obiezioni dell’articolo di Thompson.

La prima obiezione riguarda la potenza elettrica. Le stime di Thompson sembrano volutamente esagerate. Prima di tutto, all’inizio parla di TPU e GPU, ma poi si limita al confronto solo con le GPU, perché ovviamente commercialmente più disponibili. Le TPU hanno un consumo di circa 200 W a unità (TPUv4, studiate apposta per il risparmio energetico, non ho i dettagli di Trilluim) al posto di 700 W, e un cluster AI di Google per il training ne usa circa 20.000, non 100.000.

Sulla dissipazione del calore ne ho parlato già tante volte, invano, qui sul forum. Il problema è già risolto in un sistema senza accumulo, come quello di project Suncatcher. Un satellite quando raggiunge la temperatura di equilibro dissipa quanto assorbe. Non importa se l’energia del Sole è prima trasformata in elettrica dai pannelli e poi in calore dalla CPU. Il flusso è costante. Non ci sono batterie nel project Suncatcher, quindi non ci possono essere dei picchi. Il sistema dissipa sempre tanti Watt quanti ricevuti dal Sole. Il modello comparativo con la ISS non ha senso con questo progetto (con altri tipi di satellite sì, sono d’accordo con lei).

Sulle radiazioni invece lo studio è conclusivo. Intanto, per rispondere alla domanda di Thompson, l’orbita è SSO, e sinceramente mi pare molto strano che si ponga questa domanda, è l’unica orbita dove avrebbe un senso collocare questo tipo di sistemi. La Trillium è stata testata contro i SEU a livelli di radiazioni leggermente superiori a quelli in SSO, dimostrato l’efficacia di funzionamento in quell’ambiente. Sul paper ci sono in dettaglio in numeri, sull’articolo di Thompson si cita solo una frequenza di SEU più alta senza fare una stima numerica. Da notare che i SEU ci sono pure a Terra, anzi la settimana scorsa era l’argomento più trattato dagli appassionati di aeronautica.

Sulle comunicazioni tra membri del cluster si superano tranquillamente i 100 Gb/s citati come estremo inferiore nell’articolo divulgativo. Gli 800 Gb/s raggiunti sono in un abiente ideale, è vero, ma siamo comunque quasi a un ordine di grandezza maggiore. Sulle comunicazioni a Terra ammetto di non essermi documentato a sufficienza e non commento.

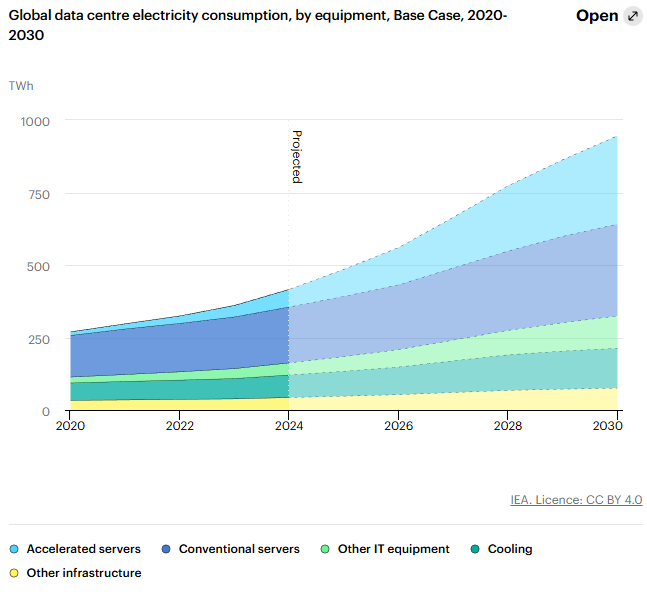

Sulle conclusioni mi trova d’accordo, è fattibile ma difficile, infatti sarebbe un prototipo. I costi sarebbero maggiore di farlo a Terra e le prestazioni peggiori. Manca la considerazione sulla scalabilità, che è proprio quello il motivo che spinge a sviluppare la tecnologia. Un datacenter AI in orbita scala senza problemi oltre i limiti attuali della richiesta, un datacenter AI a Terra no.

Costo e prestazioni non sono accattivanti al momento. In futuro lo saranno. La scommessa sta solo nel determinare il tempo di ritorno dell’investimento.